在线客服

扫描二维码

下载博学谷APP

扫描二维码

关注博学谷微信公众号

今天本文要讲解的是Hadoop集群动态扩容的内容,那么什么是动态扩容呢?数据量随着公司业务的增长越来越大,原有的datanode节点的容量,已经不能满足存储数据的需求,需要在原有集群基础上,动态添加新的数据节点,这就是我们说的动态扩容。下面一起来看看基础准备、添加datanode、datanode负载均衡服务、添加nodemanager等相关内容吧~

1、基础准备

在基础准备部分,主要是设置 hadoop 运行的系统环境

修改新机器系统 hostname(通过/etc/sysconfig/network 进行修改)

[root@node-4 ~]# cat /etc/sys conf 1g/network

NE TWORKING=yes

HOS TNAME=node -4

[r oot@node-4 ~ ] #

修改 hosts 文件,将集群所有节点 hosts 配置进去(集群所有节点保持hosts文件统一)

rootenode-1 -]# cat /etc/hosts

127.0.0.1 localhost localhost. localdomain localhost4 localhost4. local domain4

: :1 localhost localhost. localdomain localhost6 localhost6. local domain6

192.168.227.151 node-1

192.168.227.152 node-2

192.168.227.153 node-3

192.168.227.154 node-4

rootenode-1 ~]#

设置 NameNode 到 DataNode 的免密码登录(ssh-copy-id 命令实现)

修改主节点 slaves 文件,添加新增节点的 ip 信息(集群重启时配合一键启动脚本使用)

[root@node-1 J]# vim /export/servers/hadoop-2 .6. 0-cdh5.14.0/etc/hadoop/s laves

node-1

node-2

node-3

node-4

在新的机器上上传解压一个新的hadoop安装包,从主节点机器上将hadoop的所有配置文件,scp到新的节点上。

2、添加datanode

在namenode所在的机器的/export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop 目录下创建 dfs.hosts 文件

cd /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop

vim dfs.hosts

添加如下主机名称(包含新服役的节点)

node-1

node-2

node-3

node-4

在 namenode 机器的 hdfs-site.xml 配置文件中增加 dfs.hosts 属性

cd /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop vim hdfs-site.xml

<property>

<name>dfs.hosts</name>

<value>/export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop/dfs.hosts</value>

</property>

dfs.hosts 属性的意义:命名一个文件,其中包含允许连接到namenode的主机列表。必须指定文件的完整路径名。如果该值为空,则允许所有主机。相当于一个白名单,也可以不配置。

在新的机器上单独启动datanode:hadoop-daemon.sh start datanode

[root@node-4 ~]# hadoop-daemon.sh start datanode

starting datanode: logging to /export /servers/hadoop-2.6.0-cdh514 .0/ lops /hadoop root datanode -node-4 out

[root@node-4 ~]#

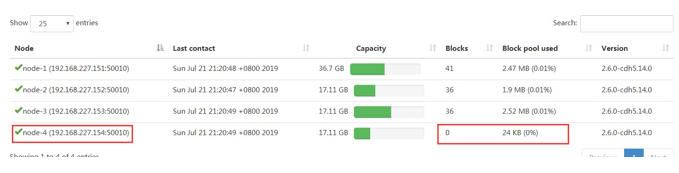

刷新页面就可以看到新的节点加入进来了

3、datanode负载均衡服务

新加入的节点,没有数据块的存储,使得集群整体来看负载还不均衡。因此最后还需要对hdfs负载设置均衡,因为默认的数据传输带宽比较低,可以设置为64M,即hdfs dfsadmin -setBalancerBandwidth 67108864即可

默认balancer的threshold为10%,即各个节点与集群总的存储使用率相差不超过10%,我们可将其设置为5%。然后启动Balancer,sbin/start-balancer.sh -threshold 5,等待集群自均衡完成即可。

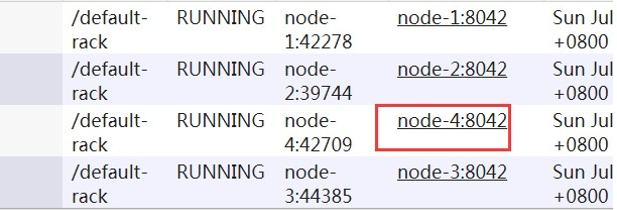

4、添加nodemanager

在新的机器上单独启动 nodemanager:

yarn-daemon.sh start nodemanager

在ResourceManager,通过yarn node -list查看集群情况

以上就是Hadoop集群动态扩容讲解的全部内容,如果你还想更加深入的学习相关内容,可以报名博学谷的大数据课程,在线学习相关视频课程,还有在线讲师一对一为你答疑解惑!

— 申请免费试学名额 —

在职想转行提升,担心学不会?根据个人情况规划学习路线,闯关式自适应学习模式保证学习效果

讲师一对一辅导,在线答疑解惑,指导就业!

相关推荐 更多

数据能力如何体现数据价值?

数据资产的价值分两部分:数据资产直接变现的价值;通过数据资产作为资源加工后提供数据服务的业务价值。底层数据加工计算所涉及到的传输效率,决定了支撑数据产品高性能、高可靠的自身需求;应用层的传输影响了用户体验和场景实现。

7829

2020-02-13 16:45:17

HDFS入门基础学习总结

HDFS全称就是Hadoop分布式文件系统,作为Hadoop的核心组件,它提供了最底层的分布式存储服务。本文整理了HDFS设计目标和HDFS的重要特性等等内容,下面一起来看HDFS入门基础学习总结吧~

5823

2020-06-09 16:19:01

大数据软件学习入门技巧

大数据软件学习入门技巧,一般而言,在进行大数据处理时,会先使用大数据数据库,如 MongoDB、 GBase等。然后利用数据仓库工具,对数据进行清理、转换、处理,得出有价值的数据。接着用数据建模工具建模。最终用大数据工具进行可视化分析。

5293

2020-07-06 15:07:49

如何利用大数据构建用户画像?

大数据时代,不仅普通用户可以享受到技术带来的便利,企业也可以从数据中提取有商业价值的信息,构建出用户画像,从而对用户行为进行分析和预测。虽然用户画像不是什么新鲜的概念,但是大数据技术的出现使得用户画像更加清晰客观。下面我们一起来看看如何利用大数据构建用户画像。

6571

2020-07-23 12:12:02

为什么大数据技术那么火?

大数据技术的概念早在2008年被Google提出。在我国2012年提出《大数据研究和发展计划》,从此我国的开放、共享和只能的大数据时代正式开启。随着一线互联网企业在大数据领域的成熟应用,以及国内政策的支持。2016年,云计算大数据技术再次成为人们所追捧的热门技术,与此同时国内大数据人才培养体系逐渐完善,为大数据的普及应用提供源源不断的人才支撑。

5642

2020-09-15 17:36:12