在线客服

扫描二维码

下载博学谷APP

扫描二维码

关注博学谷微信公众号

Pandas如何分块处理大文件?在处理快手的用户数据时,碰到600M的txt文本,用sublime打开蹦了,用pandas.read_table()去读竟然花了小2分钟,打开有3千万行数据。仅仅是打开,要处理的话不知得多费劲。

解决:读取文件的函数有两个参数:chunksize、iterator。原理分多次不一次性把文件数据读入内存中。

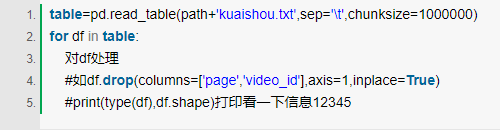

1.指定chunksize分块读取文件

read_csv 和 read_table 有一个 chunksize 参数,用以指定一个块大小(每次读取多少行),返回一个可迭代的 TextFileReader 对象。

对文件进行了划分,分成若干个子文件分别处理(to_csv也同样有chunksize参数)

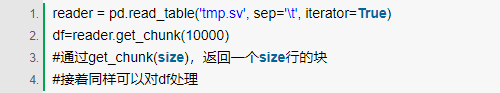

2.指定iterator=True

直接看pandas文档相关的内容。

— 申请免费试学名额 —

在职想转行提升,担心学不会?根据个人情况规划学习路线,闯关式自适应学习模式保证学习效果

讲师一对一辅导,在线答疑解惑,指导就业!

相关推荐 更多

大数据思维到底是什么?

大数据并不是简单的描述大量的数据,其中涉及到很多的数据分析以及技术实现的问题。现在很多大数据专家,学者纷纷提出大数据思维的概念以及外延理解,无论是哪个版本,大数据思维主要包含全样思维、容错思维、以及相关思维几个方面。那大数据思维到底是什么呢?接下来为大家详细说明。

17764

2019-06-24 18:22:26

云计算之云的分类

云计算大数据是现在发展的时代趋势,然而还是有很多人还不懂什么是云计算。本文就云的分类为切入点,为大家简单介绍一下云计算,让大家都能大概了解云计算的概念。

9538

2019-08-01 13:06:01

博学谷云计算大数据培训班课程怎么样?

在线学习已经成为现在年轻人最主要的学习途径。博学谷作为国内高端的IT在线教育平台,依托传智播客13年教学经验的沉淀,推出云计算大数据培训课程。每年都有非常多的小伙伴在博学谷平台学习,对于还在观望的同学,博学谷云计算大数据培训班课程怎么样?在博学谷学习有什么优势呢?

6814

2019-09-06 18:22:40

数据分析应用在哪些领域?都起到了什么作用?

随着大数据的发展,数据分析早已渗透各行业各业,尤其是互联网、电商和金融三大行业。同时数据分析在电信、旅游、医疗健康等等领域,也有比较多的应用。下面我们来看看在这些领域数据分析究竟起了什么作用。

13868

2019-09-28 09:54:27

数据中台对企业有哪些意义和作用?

随着数据化浪潮席卷全球,数据中台也由此应运而生。众所周知,数据中台的主要作用在于把数据进行统一标准和口径之后,再进行储存和加工,从而使企业可以提供更高效的服务。简单来讲,数据中台是以节省企业成本,实现精细化运营为目标。那么数据中台对企业到底有哪些具体意义和作用呢?下面我们来具体看一下。

8815

2020-02-10 22:29:52